En matemáticas, y concretamente en álgebra lineal, una matriz es de diagonal estrictamente dominante, cuando lo es por filas o por columnas.

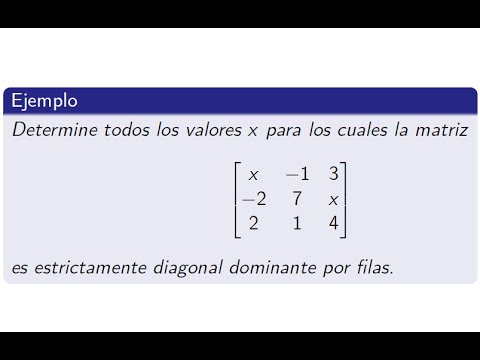

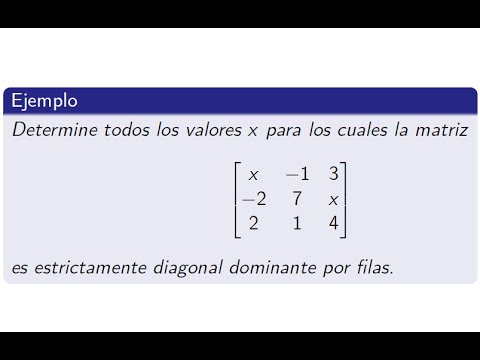

- Lo es por filas cuando, para todas las filas, el valor absoluto del elemento de la diagonal de esa fila es estrictamente mayor que la norma del resto de elementos de esa fila.

- Lo es por columnas cuando, para todas las columnas, el valor absoluto del elemento de la diagonal de esa columna es estrictamente mayor que la norma del resto de elementos de esa columna.

Formalmente, se dice que la matriz A de n x n es estrictamente diagonal dominante por filas cuando se satisface:

Lema de Hadamard

Enunciado

Si es una matriz de diagonal estrictamente dominante, entonces es invertible.

Demostración

Por Contrarrecíproco. Supongamos que no es invertible, entonces su núcleo no se reduce a cero

existe entonces un vector : tal que .

Entonces, se tiene que:

Como , existe tal que .

Tenemos : , de donde ,

y como : ,

se obtiene

Finalmente, , con lo que culmina la demostración.

Podemos enunciar a partir de esta definición el siguiente teorema de convergencia aplicable a los procesos iterativos de Jacobi y Gauss Seidel: